Optimización directa de preferencias (OPD): hacia una IA más inteligente

Además de los nuevos productos de IA que llegan al mercado a un ritmo frenético, la inteligencia artificial y la investigación en este campo siguen evolucionando a un ritmo impresionante, gracias sobre todo a innovadores métodos de optimización. Entre ellos cabe citar La Optimización de Preferencia Directa (OPD)destaca como un enfoque prometedor.

A diferencia de los métodos de aprendizaje tradicionales, que se basan principalmente en la maximización de una función de recompensa, la OPD trata de alinear las decisiones de los modelos lingüísticos (LLM) con las preferencias humanas explícitas. En general, los métodos tradicionales suelen requerir un modelo de recompensa complejo, lo que puede alargar y complicar el proceso de optimización.

Esta técnica parece prometedora para el desarrollo de sistemas de IA más inteligentes y adaptados a las necesidades de los usuarios.

¿Qué es la Optimización de Preferencia Directa (OPD)?

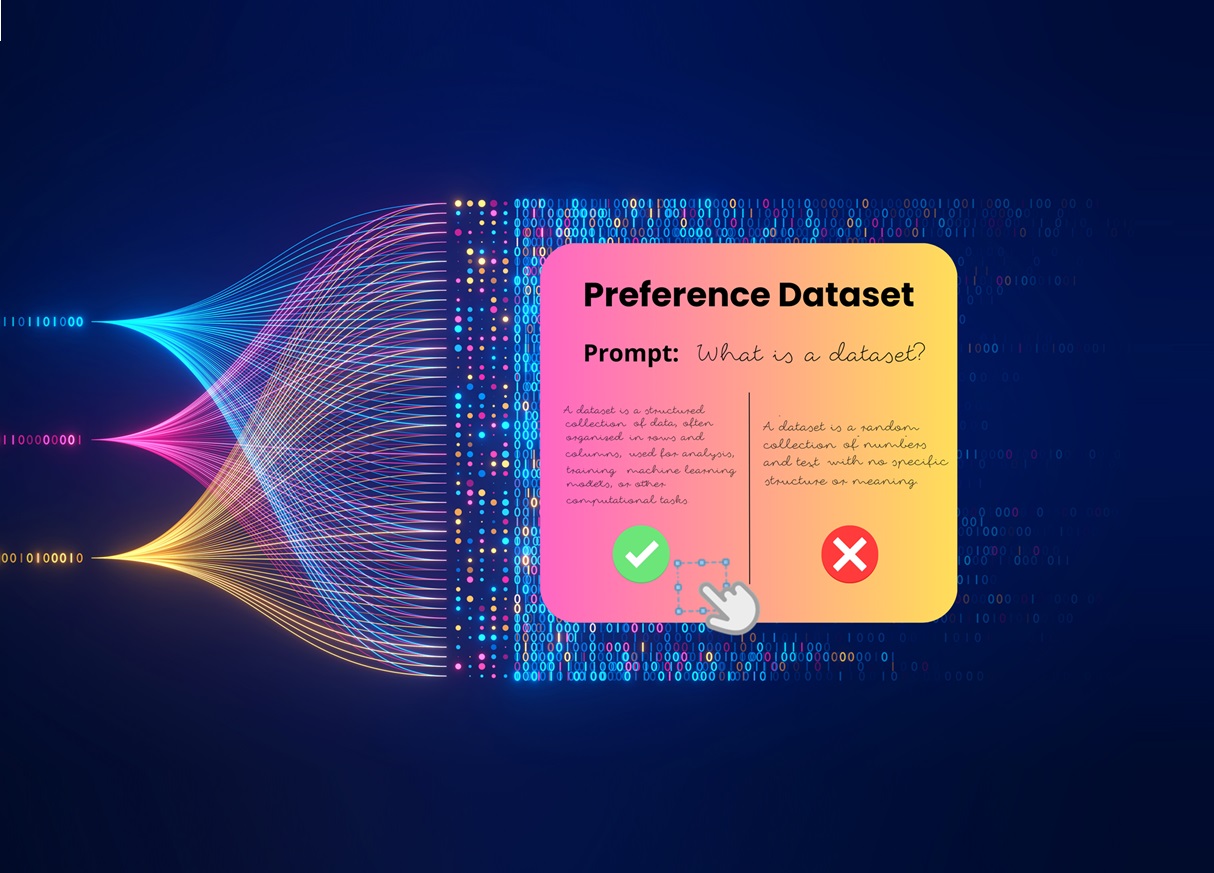

La Optimización por Preferencia Directa (OPD) es un método de optimización aplicado en el campo de la inteligencia artificial, cuyo objetivo es ajustar directamente los modelos en función de las preferencias humanas. A diferencia de los enfoques tradicionales que se basan en señales de recompensa explícitas o implícitas, la OPD se basa en juicios humanos para guiar el comportamiento de los modelos.

En RLHF (reinforcement learning from human feedback) es un método muy utilizado para alinear los modelos de IA con las preferencias humanas, pero requiere un modelo de recompensa complejo. En otras palabras, en lugar de maximizar una función de recompensa predefinida, el RLHF trata de alinear las decisiones del modelo con las preferencias expresadas por los usuarios. Esto permite crear sistemas de IA más intuitivos y más acordes con las expectativas humanas, sobre todo en contextos en los que las preferencias no siempre son fácilmente cuantificables.

Este método es especialmente útil en escenarios en los que es difícil definir criterios de rendimiento estándar o en los que es importante priorizar la experiencia del usuario, como en la generación de textos, la recomendación de contenidos o la personalización de interfaces. La RPD destaca, por tanto, por su capacidad para acercar los modelos de IA a las expectativas subjetivas de los usuarios, ofreciendo una mejor adaptación a las preferencias específicas.

¿En qué se diferencia la OPD de otros métodos de optimización, principalmente el aprendizaje por refuerzo?

La Optimización Directa de Preferencias (OPD) difiere principalmente del Aprendizaje por Refuerzo (AR) en la forma en que se utilizan las preferencias y las recompensas para ajustar los modelos de IA. El aprendizaje por refuerzo (RL) presenta desafíos, como la dificultad de obtener conjuntos de datos anotados y la necesidad de modelos de recompensa complejos.

Uso de recompensas

En el aprendizaje por refuerzo, un agente interactúa con un entorno realizando acciones y recibiendo recompensas a cambio. Estas recompensas, positivas o negativas, guían al agente para que aprenda a maximizar el beneficio a largo plazo.

Por tanto, la RA se basa en un modelo de recompensa predefinido, que debe comprenderse y definirse bien para obtener resultados óptimos. Sin embargo, en algunas situaciones, las preferencias humanas no son fácilmente cuantificables en términos de recompensas explícitas, lo que limita la flexibilidad de la RA.

En cambio, la OPD sortea esta limitación basándose directamente en las preferencias humanas. En lugar de intentar definir una función de recompensa objetiva, OPD tiene en cuenta juicios humanos explícitos entre distintas opciones o resultados. Los usuarios comparan directamente los resultados de varios modelos, y sus preferencias guían la optimización del modelo sin tener que pasar por una fase intermedia de recompensa cuantificada.

La complejidad de las preferencias humanas

Aunque el aprendizaje por refuerzo puede funcionar bien en entornos donde las recompensas son fáciles de formalizar (por ejemplo, en juegos o tareas robóticas), se vuelve más complejo en contextos donde las preferencias son subjetivas o difíciles de modelar.

La RPD, en cambio, está diseñada para captar mejor estas preferencias sutiles e incuantificables, lo que la hace más adecuada para tareas como la personalización, la recomendación o la generación de contenidos, en las que las expectativas varían considerablemente de un usuario a otro.

Enfoque de optimización

El aprendizaje por refuerzo trata de optimizar las acciones del agente mediante un proceso de ensayo y error, maximizando una función de recompensa a largo plazo. Es necesario ajustar los modelos lingüísticos para garantizar que sus resultados coincidan con las preferencias humanas. La OPD adopta un enfoque más directo, alineando el modelo con las preferencias humanas mediante comparaciones por pares o clasificaciones, sin pasar por el paso de simular la interacción con el entorno.

Preferencias humanas en la IA

Las preferencias humanas desempeñan un papel clave en el desarrollo de la inteligencia artificial (IA). Para que los sistemas de IA sean realmente eficaces, deben ser capaces de comprender y responder a las necesidades y expectativas de los usuarios. Aquí es donde entra en juego la Optimización Directa de Preferencias (OPD), que permite alinear las decisiones de los modelos de IA con las preferencias humanas explícitas.

El enfoque de la OPD se distingue por su capacidad de incorporar juicios humanos directamente al proceso de optimización. A diferencia de los métodos tradicionales, que se basan en funciones de recompensa a menudo abstractas, la OPD utiliza las preferencias humanas para guiar el aprendizaje de los modelos. Esto permite crear sistemas de IA más intuitivos y más acordes con las expectativas de los usuarios, sobre todo en contextos en los que las preferencias no son fácilmente cuantificables.

Al incorporar las preferencias humanas, la RPD permite desarrollar modelos de IA que no sólo son más precisos, sino que también se adaptan mejor a las necesidades específicas de los usuarios. Este enfoque es especialmente útil en ámbitos como la personalización de servicios, la recomendación de contenidos y la generación de textos, en los que las expectativas varían considerablemente de un usuario a otro.

¿Cuáles son las ventajas de la RPD para entrenar modelos de IA?

La Optimización Directa de Preferencias (OPD) ofrece una serie de ventajas significativas para el entrenamiento de modelos de inteligencia artificial, sobre todo cuando se trata de alinear modelos con preferencias humanas más refinadas y matizadas. He aquí sus principales ventajas:

Alineación directa con las preferencias humanas

A diferencia de los métodos tradicionales, que se basan en funciones de recompensa a menudo difíciles de definir o inadaptadas a criterios subjetivos, la OPD permite captar directamente las preferencias de los usuarios. El ajuste fino de los hiperparámetros y los datos etiquetados es esencial para garantizar que los resultados del modelo coincidan con las preferencias humanas. Al incorporar estas preferencias al proceso de formación, el modelo es más capaz de satisfacer las expectativas reales de los usuarios.

Mejor gestión de las preferencias subjetivas

En ámbitos en los que los criterios de rendimiento no pueden cuantificarse fácilmente (como la satisfacción del usuario, la generación de contenidos o la recomendación de productos), la RPD permite gestionar mejor estas preferencias subjetivas, que a menudo se pasan por alto en los enfoques tradicionales. Esto permite a los modelos de IA tomar decisiones más matizadas, en consonancia con las necesidades individuales de los usuarios.

Reducir el sesgo inducido por las métricas de rendimiento

Las funciones de recompensa o las métricas de rendimiento pueden introducir sesgos no deseados en el entrenamiento de los modelos lingüísticos (LLM). La OPD, al permitir que los usuarios emitan juicios directos, contribuye a limitar estos sesgos al alejarse de la optimización puramente numérica e incorporar criterios subjetivos más flexibles.

Mejorar la calidad de las decisiones

La OPD permite a los modelos de IA tomar decisiones más acordes con las preferencias humanas en situaciones complejas o ambiguas. Esto es especialmente útil en aplicaciones como la generación de textos, la recomendación de contenidos y la personalización de servicios, donde la experiencia del usuario es primordial.

Adaptación a escenarios cambiantes

Las preferencias humanas pueden evolucionar con el tiempo, y las funciones de recompensa rígidas no siempre captan estos cambios. La OPD permite adaptar los modelos con mayor fluidez reevaluando constantemente las preferencias humanas a través de nuevos datos o de una retroalimentación continua.

Utilización en entornos no estacionarios

En entornos en los que las condiciones cambian rápidamente (por ejemplo, plataformas de recomendación o asistentes virtuales), la OPD permite una mayor flexibilidad al ajustar los modelos de IA en función de la información directa de los usuarios, sin necesidad de redefinir constantemente las funciones de recompensa.

Metodología y aplicaciones de la RPD

La metodología de la OPD se basa en la recogida y el uso de datos sobre preferencias humanas para optimizar los parámetros de los sistemas de IA. En la práctica, se trata de recabar opiniones explícitas de los usuarios sobre los resultados de distintos modelos y utilizarlas para ajustar los modelos a las expectativas humanas.

Este enfoque puede aplicarse a multitud de campos. Por ejemplo, en el sector sanitario, la OPD puede mejorar los sistemas de IA encargados de diagnosticar enfermedades o sugerir tratamientos personalizados. En finanzas, puede optimizar los sistemas de IA que intervienen en la toma de decisiones de inversión, teniendo en cuenta las preferencias específicas de los inversores.

La OPD también está en el centro de numerosos proyectos de investigación académica. En la Universidad de Stanford, investigadores como Stefano Ermon, Archit Sharma y Chelsea Finn exploran el potencial de este enfoque para mejorar la precisión y eficacia de los sistemas de IA. Su trabajo demuestra que la OPD puede revolucionar la forma en que se entrenan los modelos de IA.

En resumen, la OPD es un enfoque innovador que utiliza las preferencias humanas para optimizar el rendimiento de los sistemas de IA. Sus aplicaciones son amplias y variadas, desde la sanidad y las finanzas hasta la tecnología y la investigación académica. Gracias a la OPD, los modelos de IA pueden ser más inteligentes, intuitivos y adaptarse mejor a las necesidades de los usuarios.

¿Qué importancia tiene la anotación de datos en la RPD?

La anotación de datos es esencial en la OPD, ya que permite captar directamente las preferencias humanas en conjuntos de datos pequeños o masivos. Al proporcionar juicios explícitos sobre los resultados del modelo, la anotación ayuda a adaptar los resultados a las expectativas del usuario.

También mejora la calidad de los datos de entrenamiento, reduce los sesgos asociados a los métodos tradicionales (suponiendo que los anotadores que trabajan en el conjunto de datos hayan sido rigurosamente seleccionados) y permite adaptar continuamente los modelos a las preferencias cambiantes. En resumen, la anotación de datos garantiza que los modelos de IA se ajusten a las necesidades reales de los usuarios.

En conclusión

La optimización directa de las preferencias (OPD) podría representar un gran avance en el entrenamiento de modelos de inteligencia artificial, al permitir una alineación más precisa con las preferencias humanas. Al incorporar juicios explícitos y centrarse en las necesidades subjetivas de los usuarios, este método promete mejores sistemas de IA, intuitivos y adaptados a contextos complejos.

En este contexto, la anotación de datos desempeña un papel fundamental, ya que garantiza que los modelos se mantengan en sintonía con las expectativas cambiantes de los usuarios. A medida que se multiplican las aplicaciones de IA, la OPD se perfila como un enfoque clave para crear modelos verdaderamente inteligentes.