¿Acuerdo entre anotadores o cómo controlar la fiabilidad de los datos evaluados para la IA?

¿Qué es el Acuerdo entre Anotadores (AIA) y por qué es importante?

Un Acuerdo entre Anotadores (IAA) es una medida de la concordancia o coherencia entre cada anotación producida por diferentes anotadores que trabajan en la misma tarea o conjunto de datos, como parte de la preparación de un conjunto de datos de entrenamiento para IA. El acuerdo entre anotadores evalúa hasta qué punto los anotadores están de acuerdo en las anotaciones asignadas a un conjunto de datos (o 🔗 conjunto de datos).

La importancia del acuerdo entre anotadores radica en su capacidad para proporcionar una indicación científica y precisa de las evaluaciones. En los campos anteriormente mencionados, en particular el desarrollo de productos de IA que dependen de big data, las decisiones y conclusiones a menudo dependen de cada anotación proporcionada por 🔗 anotadores humanos. Sin una forma de medir y garantizar la coherencia de estas anotaciones, ¡los resultados obtenidos pueden ser sesgados o poco fiables!

IAA permite cuantificar y comprobar la coherencia de cada anotación. Esto ayuda a mejorar la calidad de los datos anotados y la solidez de los análisis resultantes y, por supuesto, los resultados producidos por sus modelos de IA. Al identificar las discrepancias entre los anotadores, el Acuerdo entre Anotadores también ayuda a identificar los puntos de desacuerdo y a aclarar los criterios de anotación. Esto puede mejorar la coherencia de las anotaciones realizadas posteriormente, durante el ciclo de preparación de los datos para la IA.

¿Cómo contribuye el Acuerdo entre Anotadores a garantizar la fiabilidad de las anotaciones en la IA?

El acuerdo entre anotadores es una métrica que contribuye a la fiabilidad de las evaluaciones de varias maneras:

Medición de la coherencia de las anotaciones

El IAA proporciona una medida cuantitativa de la concordancia entre cada anotación asignada por diferentes anotadores. Al evaluar esta concordancia, podemos determinar la fiabilidad de las evaluaciones e identificar las áreas en las que existen discrepancias entre los anotadores.

Identificación de errores y ambigüedades

Al comparar cada anotación, es decir, los metadatos producidos por diferentes anotadores en un conjunto de datos específico, el Acuerdo entre Anotadores permite identificar posibles errores. Al mismo tiempo, identifica ambigüedades en las instrucciones de anotación (o manuales de anotación) y lagunas en la formación de los anotadores. Al corregir estos errores, podemos mejorar la calidad de los metadatos, los conjuntos de datos producidos y , en última instancia, ¡la IA!

Aclaración de los criterios de anotación

El acuerdo entre anotadores puede ayudar a aclarar los criterios de anotación identificando los puntos de desacuerdo entre los anotadores. Al examinar estos puntos de desacuerdo, es posible aclarar las instrucciones de anotación y, a continuación, proporcionar formación adicional a los anotadores. Se trata de una buena práctica para mejorar la coherencia de las evaluaciones.

Optimización del proceso de anotación

Mediante el seguimiento periódico del Acuerdo entre Anotadores, es posible identificar tendencias y problemas recurrentes en las evaluaciones, en conjuntos de datos en construcción. Esto ayuda a optimizar el proceso de anotación, ya sea de imágenes o 🔗 vídeos en particular, aplicando medidas correctoras sobre la marcha para mejorar la fiabilidad de las evaluaciones de los conjuntos de datos a largo plazo.

¿Cuáles son los métodos habituales para evaluar la fiabilidad de una anotación?

Se suelen utilizar varios métodos para evaluar la fiabilidad de cada anotación. He aquí algunos de los métodos más habituales:

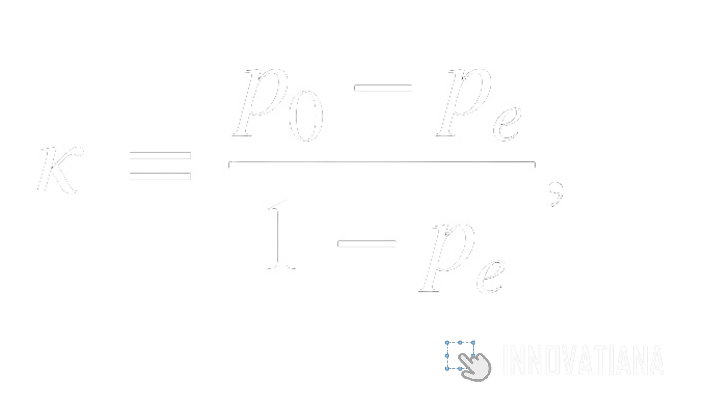

Coeficiente Kappa de Cohen

El coeficiente Kappa de Cohen es una medida estadística que evalúa el acuerdo entre dos anotadores corregido por la posibilidad de acuerdo aleatorio. Se calcula comparando la frecuencia observada de acuerdo entre anotadores con la frecuencia esperada de acuerdo por azar. Este coeficiente varía de -1 a 1, donde 1 indica acuerdo perfecto, 0 indica acuerdo equivalente al obtenido por azar y -1 indica desacuerdo perfecto. Esta medida se utiliza mucho para evaluar la fiabilidad de las anotaciones binarias o categóricas, como las anotaciones de presencia o ausencia, o las anotaciones que clasifican a las personas en categorías predefinidas (por ejemplo, perro, gato, tortuga, etc.).

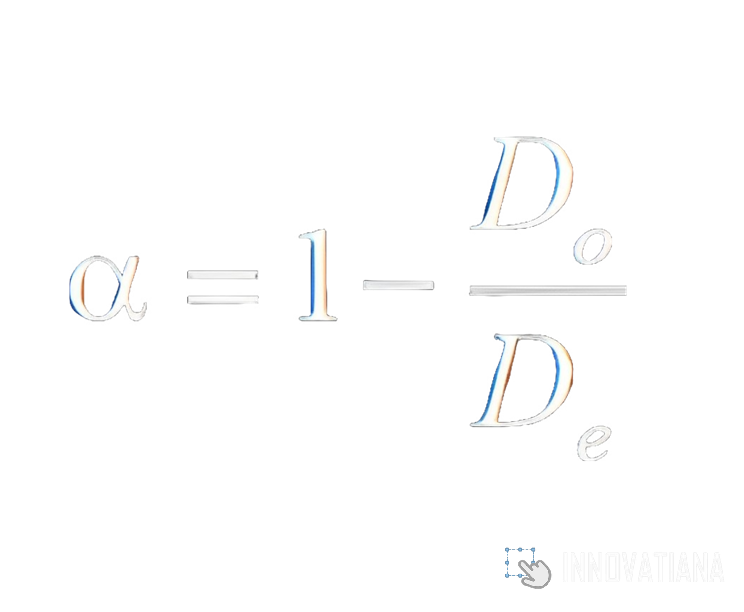

Coeficiente alfa de Krippendorff

El coeficiente alfa de Krippendorff es una medida de fiabilidad entre anotadores que evalúa la concordancia entre varios anotadores para datos categóricos, ordinales o nominales. A diferencia del Kappa de Cohen, puede aplicarse a conjuntos de datos con más de dos anotadores. El coeficiente alfa de Krippendorff tiene en cuenta el tamaño de la muestra, la diversidad de categorías y la posibilidad de acuerdo por azar. Oscila entre 0 y 1, donde 1 indica un acuerdo perfecto y 0 un desacuerdo total. Esta medida es especialmente útil para evaluar la fiabilidad de las anotaciones en situaciones en las que intervienen varios anotadores, como en los estudios entre anotadores.

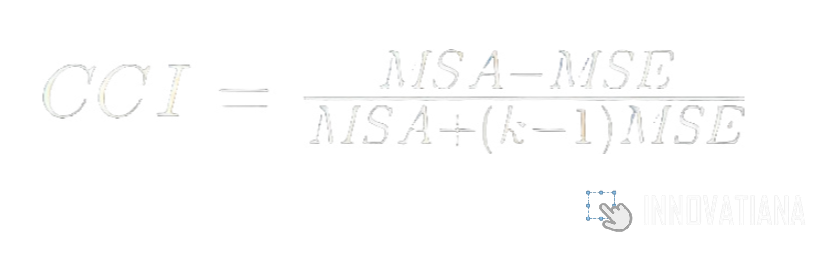

Coeficiente de correlación intraclase (CCI)

El coeficiente de correlación intraclase es una medida de fiabilidad utilizada para evaluar la concordancia entre las anotaciones continuas u ordinales de varios anotadores. Se calcula comparando la varianza entre las anotaciones de los anotadores con la varianza total. Así se obtiene una estimación de la proporción de varianza atribuible al acuerdo entre los anotadores. El CCI oscila entre 0 y 1, donde 1 indica un acuerdo perfecto y 0 un desacuerdo total. Esta medida es especialmente útil para evaluar la fiabilidad de las medidas cuantitativas u ordinales, como las evaluaciones de rendimiento o de calidad.

Análisis de las discrepancias

El análisis de discrepancias consiste en examinar los casos en que los anotadores difieren en sus anotaciones, para identificar posibles fuentes de desacuerdo. Esto puede incluir el examen de casos en los que los anotadores interpretaron las instrucciones de forma diferente, casos en los que las instrucciones eran ambiguas o casos en los que los anotadores carecían de formación sobre la tarea de anotación. Este análisis permite comprender las razones de las discrepancias entre anotadores e identificar formas de mejorar la coherencia de las anotaciones en el futuro.

Análisis de fiabilidad interna

El análisis de la fiabilidad interna evalúa la coherencia interna de las anotaciones examinando la concordancia entre diferentes anotaciones del mismo anotador. Puede incluir medidas como la consistencia intra-anotador, que evalúa la estabilidad de las anotaciones de un anotador a lo largo de varias evaluaciones de la misma tarea. Este análisis se utiliza para determinar si las anotaciones de un anotador son coherentes y fiables a lo largo del tiempo.

Análisis de los márgenes de error

El análisis del margen de error evalúa la variabilidad de las anotaciones examinando las discrepancias entre las anotaciones de un mismo anotador sobre elementos similares. Esto puede incluir el examen de casos en los que un anotador ha asignado anotaciones diferentes a elementos que deberían ser similares según las directrices de anotación. Este análisis permite cuantificar la precisión de las anotaciones e identificar los elementos más propensos a errores. Esto puede proporcionar información valiosa para mejorar las instrucciones de anotación o formar a los anotadores.

¿Cómo puede utilizarse eficazmente el acuerdo entre anotadores en los procesos de anotación para la IA?

Para establecer un proceso de anotación AI eficaz, puede utilizarse el Acuerdo entre Anotadores como métrica de control de calidad. Para aplicar esta métrica, hay que seguir varios pasos clave. En primer lugar, es importante definir claramente las instrucciones de anotación especificando los criterios que deben seguirse al anotar los datos. Estas instrucciones deben ser precisas, completas y fáciles de entender para los anotadores (o etiquetadores de datos). Para una mayor eficacia, es preferible proporcionarles una formación en profundidad sobre la anotación y la tarea en cuestión. Es fundamental que los etiquetadores de datos comprendan perfectamente las instrucciones y sean capaces de aplicarlas de forma coherente.

Antes de poner en marcha el proceso de anotación a gran escala, es aconsejable realizar un ensayo piloto, es decir, una prueba con un pequeño conjunto de datos y varios anotadores. Esto permite detectar y corregir cualquier problema en las instrucciones de anotación o en la comprensión de los anotadores. La supervisión continua del proceso de anotación también es necesaria para detectar cualquier problema o incoherencia. Esto puede lograrse examinando periódicamente una muestra aleatoria de las anotaciones realizadas por los anotadores.

Si se detectan problemas o incoherencias, las instrucciones de anotación deben revisarse y aclararse a partir de los comentarios de los anotadores. El uso de herramientas de anotación adecuadas también puede facilitar el proceso y garantizar la coherencia de las anotaciones. Estas herramientas pueden incluir plataformas en línea especializadas en la anotación de datos o software personalizado desarrollado internamente.

Una vez completadas las anotaciones, es necesario evaluar la fiabilidad entre anotadores mediante métodos como Kappa de Cohen o alfa de Krippendorff, que cuantificarán el acuerdo entre anotadores e identificarán las fuentes de desacuerdo. Por último, los resultados de la evaluación de la fiabilidad entre anotadores deben analizarse para identificar posibles errores e incoherencias en las anotaciones. A continuación, deben corregirse revisando las anotaciones en cuestión y aclarando las instrucciones de anotación si es necesario.

💡 ¿Quieres saber más y aprender a construir conjuntos de datos de calidad? 🔗 Echa un vistazo a nuestro artículo ¡!

¿Cómo se utiliza el Acuerdo entre Anotadores en el campo de la Inteligencia Artificial?

En el campo de la Inteligencia Artificial (IA), el Acuerdo entre Anotadores desempeña un papel clave para garantizar la calidad y fiabilidad de los conjuntos de datos anotados utilizados para entrenar y evaluar modelos de IA.

Entrenamiento de modelos de IA

Los modelos de IA requieren conjuntos de datos anotados para el entrenamiento y el aprendizaje automático eficaz. Es el caso de las redes neuronales profundas, los algoritmos de aprendizaje automático y los sistemas de procesamiento del lenguaje natural. El acuerdo entre anotadores se utiliza para garantizar la fiabilidad y calidad de las anotaciones en estos conjuntos de datos. El resultado son modelos más precisos y fiables.

Evaluación del rendimiento del modelo

Una vez entrenados los modelos de IA, hay que evaluarlos en conjuntos de datos de prueba para medir su rendimiento. En este contexto también se utiliza el acuerdo entre anotadores para garantizar que las anotaciones en los conjuntos de prueba sean fiables y coherentes. Esto garantiza una evaluación precisa del rendimiento del modelo.

Corrección de errores de modelización

Al analizar los resultados de los modelos de IA, a menudo es necesario identificar y corregir los errores de modelización. El acuerdo entre anotadores puede utilizarse para evaluar la calidad de las anotaciones en conjuntos de datos anotados e identificar áreas en las que los modelos producen resultados incorrectos. Esto ayuda a comprender las deficiencias de los modelos y a mejorar su precisión.

Desarrollo de un conjunto de datos específico

En algunos casos, es necesario crear un conjunto de datos específico para determinadas tareas de IA. El Acuerdo entre Anotadores se utiliza entonces para garantizar la calidad y coherencia de las anotaciones en este conjunto de datos. Esto permite desarrollar modelos de IA adaptados a dominios o aplicaciones específicos.

¿Cuáles son las ventajas y los inconvenientes de utilizar la LPN?

Utilizar el Acuerdo entre Anotadores tiene ventajas e inconvenientes en varios ámbitos.

Beneficios

Mediante el uso proactivo del Acuerdo entre Anotadores, los especialistas en IA o los Científicos de Datos pueden garantizar la calidad y coherencia de las evaluaciones en diversos dominios, lo que refuerza la validez de los análisis y, potencialmente, el rendimiento de los modelos. Estas son solo algunas de las ventajas:

1. Fiabilidad de las evaluaciones

El Acuerdo entre Anotadores permite medir la concordancia entre las anotaciones de distintos anotadores, lo que aumenta la confianza en las evaluaciones realizadas. Por ejemplo, en el ámbito de la investigación académica, donde los estudios se basan a menudo en el análisis de anotaciones manuales, el IAA garantiza que los resultados se basan en datos fiables y coherentes. Del mismo modo, en el desarrollo de sistemas de IA, los conjuntos de datos con anotaciones fiables son esenciales para entrenar modelos precisos.

2. Identificación de errores

Al comparar las anotaciones de varios anotadores, el Acuerdo entre Anotadores puede identificar incoherencias y errores en los datos anotados. Por ejemplo, en el campo del análisis de datos, puede revelar discrepancias en la interpretación de la información. Esto permite identificar y corregir errores. Al mismo tiempo, ayuda a mejorar la calidad de los datos y a evitar posibles sesgos en análisis posteriores.

3. Aclaración de las instrucciones de anotación

Cuando los anotadores producen anotaciones divergentes, esto puede indicar ambigüedades en las instrucciones de anotación. Al identificar las áreas de desacuerdo, IAA ayuda a aclarar y refinar las instrucciones, mejorando la coherencia de las anotaciones en el futuro. Por ejemplo, en el campo de la 🔗 clasificación de imágeneslas discrepancias en la asignación de ciertas clases pueden indicar la necesidad de revisar las instrucciones para una mejor interpretación.

4. Optimización del proceso de anotación

El seguimiento periódico de las IAA permite detectar tendencias y problemas recurrentes en las evaluaciones de datos de todo tipo. Esto permite introducir mejoras continuas en el proceso de anotación, aplicando medidas correctoras para mejorar la calidad de las evaluaciones a largo plazo. Por ejemplo, si el IAA revela un descenso repentino de la concordancia entre los anotadores, ello puede indicar la necesidad de revisar las instrucciones o de impartir formación adicional a los anotadores.

Desventajas

Aunque el IAA ofrece muchas ventajas para garantizar la calidad y fiabilidad de las evaluaciones en distintos ámbitos, esta métrica también tiene sus inconvenientes.

Coste en tiempo y recursos

Poner en marcha un proceso de etiquetado y una métrica asociada, como la IAA, puede requerir mucho tiempo y recursos. Es necesario contratar y formar anotadores cualificados, supervisar el proceso de anotación, recopilar y procesar los datos anotados y analizar periódicamente las métricas para optimizar la producción de datos y metadatos. Este proceso puede llevar mucho tiempo y requerir una importante inversión financiera, sobre todo en ámbitos en los que los datos son extensos o complejos.

Complejidad de los análisis

El análisis de métricas como IAA puede resultar complejo, sobre todo cuando intervienen varios anotadores o cuando los datos anotados son difíciles de interpretar. A menudo es necesario utilizar métodos estadísticos avanzados para evaluar la concordancia entre las anotaciones e interpretar los resultados adecuadamente. Esto puede requerir conocimientos especializados en estadística o análisis de datos, lo que puede suponer un reto para algunos equipos de etiquetado de datos.

Sensibilidad a los prejuicios humanos

Los procesos de etiquetado de datos pueden verse influidos por sesgos individuales de los anotadores, como preferencias personales, interpretaciones subjetivas de las instrucciones de anotación o errores humanos. Por ejemplo, un anotador puede estar más inclinado a asignar una anotación determinada debido a sus propias opiniones o experiencias, lo que puede sesgar los modelos de IA. Es importante tomar medidas para minimizar estos sesgos, como formar a los anotadores y aclarar las instrucciones de anotación.

Limitaciones en determinados contextos

En algunos ámbitos o para algunas tareas, el uso de una métrica como IAA puede verse limitado por la naturaleza de los datos anotados. Por ejemplo, en ámbitos en los que los datos son escasos o difíciles de obtener, puede resultar difícil crear un conjunto de datos anotados fiable. Del mismo modo, en ámbitos en los que las tareas de anotación son complejas o subjetivas, puede resultar difícil contratar anotadores experimentados capaces de producir anotaciones de alta calidad.

Posibilidad de desacuerdos persistentes

A pesar de los esfuerzos por aclarar las instrucciones de anotación y armonizar las prácticas, los anotadores pueden seguir teniendo opiniones divergentes sobre determinadas anotaciones. Esto puede dar lugar a desacuerdos persistentes entre los anotadores y dificultar la resolución de las diferencias. En algunos casos, esto puede comprometer la calidad general de las evaluaciones y, por tanto, de los conjuntos de datos.

Teniendo en cuenta estos inconvenientes, es importante poner en marcha medidas para mitigar sus efectos y maximizar las ventajas de utilizar un indicador como la IA en distintas aplicaciones. Esto puede incluir una formación exhaustiva de los anotadores, la aclaración periódica de las instrucciones de anotación, un estrecho seguimiento del proceso de anotación y, sobre todo, un análisis minucioso de los resultados de la IA para identificar y corregir posibles problemas.

En conclusión

En conclusión, el Acuerdo entre Anotadores (IAA) es una herramienta esencial para garantizar la calidad y fiabilidad de los datos anotados utilizados en el campo de la inteligencia artificial. Se trata de una métrica cada vez más importante para los equipos de etiquetado de datos más maduros.

Al medir la coherencia entre los anotadores, la IAA ayuda a garantizar que los conjuntos de datos sean fiables y estén libres de sesgos, contribuyendo así a la eficacia de los modelos de IA desarrollados. A pesar de los retos, sobre todo en términos de coste y complejidad, la importancia de la IAA radica en su utilidad como métrica para mejorar continuamente el proceso de anotación.

Utilizando el IAA de forma inteligente, los equipos de científicos de datos y especialistas en IA pueden optimizar los procesos de anotación, mejorando así la calidad de los conjuntos de datos producidos. El papel del IAA en el desarrollo de datos de entrenamiento y la evaluación de modelos de IA es, por tanto, innegable, lo que convierte a este indicador en un verdadero pilar en la preparación de datos de alta calidad para las tecnologías del futuro.

-hand-innv.png)